[计算机视觉] : FAST/BRIEF 原理与 ORB 图像匹配实战

0. 背景 : 追求极致速度的特征匹配

在计算机视觉的实时应用(如 SLAM、移动端 AR)中,传统的 SIFT 或 SURF 算法虽然精度高,但计算量过大,难以满足实时性要求。

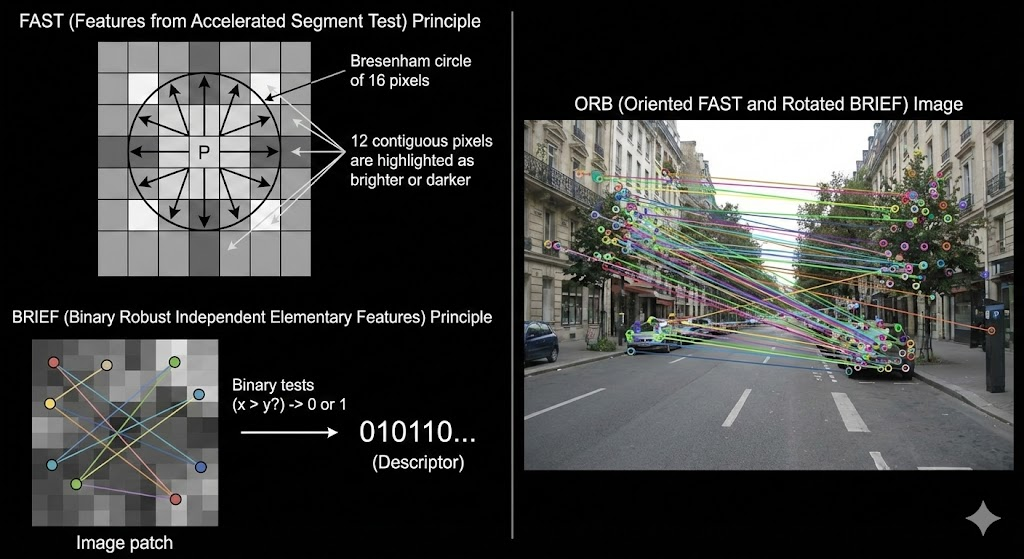

为了解决这一瓶颈,ORB (Oriented FAST and Rotated BRIEF) 算法应运而生。它并未发明全新的理论,而是将 FAST 特征点检测算法与 BRIEF 特征描述子进行了工程化组合,并在其基础上解决了旋转不变性问题。本文将拆解这两个核心组件,并演示如何使用 OpenCV 实现高效的图像匹配。

1. 核心原理 : FAST 检测器

FAST (Features from Accelerated Segment Test) 专注于“快”,其唯一任务是迅速定位角点,而不负责描述角点特征。

1.1 检测逻辑

FAST 的核心思想基于像素周围的圆形邻域检测:

-

选取中心点:在图像中选取一个像素 $P$,假设其亮度为 $I_p$。

-

设定阈值:设定一个阈值 $t$。

-

圆周检查:检查 $P$ 点周围半径为 3 的圆周上的 16 个像素点。

-

角点判定:如果圆周上存在连续 $N$ 个像素(通常 $N=12$),其亮度值均显著高于 $I_p + t$ 或显著低于 $I_p - t$,则判定 $P$ 为角点候选点。

1.2 非极大值抑制 (NMS)

由于检测标准较为宽松,往往会在同一个角点附近产生多个聚簇的候选点。FAST 使用非极大值抑制进行筛选:计算候选点与周围像素的灰度差分和(Score),仅保留局部区域内 Score 最大的点,确保角点的唯一性和准确性。

2. 核心原理 : BRIEF 描述子

BRIEF (Binary Robust Independent Elementary Features) 是一种二进制描述子。不同于 SIFT 使用浮点数向量(计算复杂、占用内存大),BRIEF 使用二进制字符串(0和1)来描述特征点。

2.1 描述子生成

-

平滑处理:对图像进行高斯平滑,降低噪声干扰。

-

点对选择:在关键点周围的邻域内,按照特定的概率分布(如高斯分布)随机选取 $n$ 对像素点 $(p_a, p_b)$。

-

二进制编码:

-

如果 $Intensity(p_a) > Intensity(p_b)$,该位记为

1。 -

否则,记为

0。

-

-

组合特征:将这 $n$ 次比较的结果串联起来,形成一个 $n$ 位(通常为 128、256 或 512 位)的二进制字符串。

注意:由于 BRIEF 本身不具备旋转不变性,OpenCV 中的 ORB 算法通过引入“主方向”计算,改进了 BRIEF 的采样模式,使其能够适应图像旋转。

3. 实战 : OpenCV ORB 匹配实现

下文代码使用 OpenCV 的 ORB 接口(内部集成了 FAST 检测与 BRIEF 描述),并配合汉明距离进行特征匹配。

3.1 依赖环境

确保已安装 opencv-python 和 numpy。

3.2 代码实现

import cv2import numpy as np

# 1. 数据准备# 读取灰度图,特征提取通常不需要色彩信息image1 = cv2.imread('01.jpg', cv2.IMREAD_GRAYSCALE)image2 = cv2.imread('02.jpg', cv2.IMREAD_GRAYSCALE)

# 检查图片是否读取成功if image1 is None or image2 is None: raise FileNotFoundError("无法加载图片,请检查路径。")

# 2. 初始化检测器# ORB 是 FAST(检测) + BRIEF(描述) 的改良版orb = cv2.ORB_create()

# 3. 特征提取# keypoints: 关键点坐标信息# descriptors: 对应的二进制特征向量keypoints1, descriptors1 = orb.detectAndCompute(image1, None)keypoints2, descriptors2 = orb.detectAndCompute(image2, None)

# 4. 特征匹配# cv2.NORM_HAMMING: 专门用于二进制描述子(如 ORB/BRIEF)的距离度量,速度极快# crossCheck=True: 开启双向验证(A匹配B且B匹配A),提高匹配准确度bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=True)

# 执行匹配matches = bf.match(descriptors1, descriptors2)

# 5. 结果筛选与展示# 按距离从小到大排序,距离越小匹配度越高matches = sorted(matches, key=lambda x: x.distance)

# 绘制前 10 个最佳匹配点# flags=2 (NOT_DRAW_SINGLE_POINTS): 不绘制未匹配的孤立特征点,保持画面整洁matched_image = cv2.drawMatches( image1, keypoints1, image2, keypoints2, matches[:10], None, flags=cv2.DrawMatchesFlags_NOT_DRAW_SINGLE_POINTS)

# 显示图像cv2.imshow('ORB Matches', matched_image)cv2.waitKey(0)cv2.destroyAllWindows()重点参数说明:

在初始化BFMatcher时,务必使用cv2.NORM_HAMMING。因为 BRIEF/ORB 生成的是二进制串,通过异或(XOR)运算计算汉明距离比计算欧氏距离(L2)快几个数量级。如果错误使用NORM_L2,不仅速度变慢,匹配结果也会完全错误。